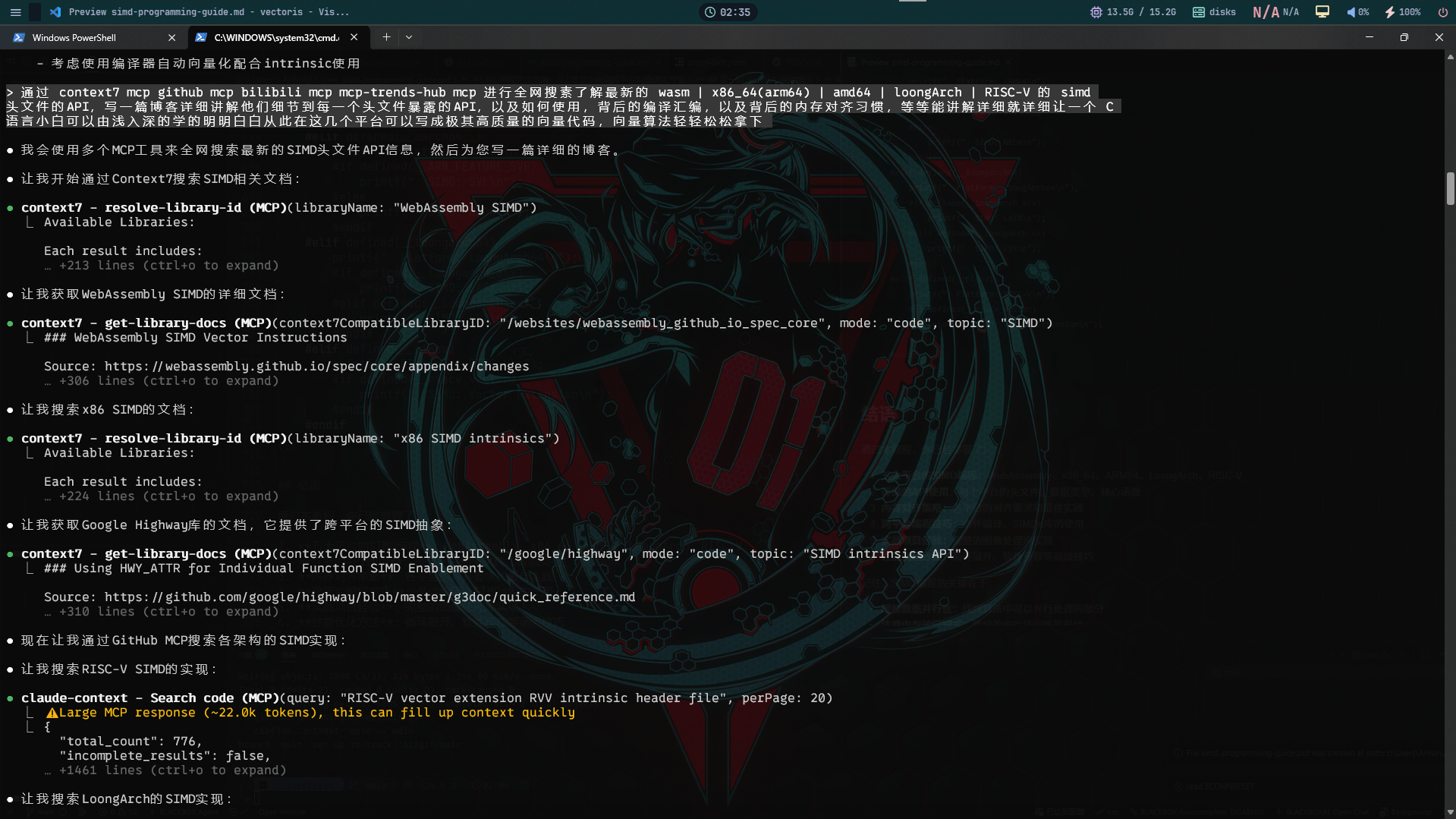

尝试用AI CLI做资料收集来学习

好玩 & 轻松交流

纯水

AnNingUI 贡献者

去年 12.9 02:41

有点意思,但是还是写的差强人意,写的大体是对的

SIMD编程完全指南:从C语言小白到跨平台向量优化专家

前言

在当今的高性能计算时代,SIMD(Single Instruction, Multiple Data)指令集已经成为程序员必备的核心技能。无论是音频视频处理、游戏开发、科学计算还是机器学习,掌握SIMD编程都能让你的代码获得数量级的性能提升。

本教程将带你深入探索WebAssembly、x86_64、ARM64、LoongArch和RISC-V这五大平台的SIMD编程,从最基本的概念到实际的项目应用,让你从一个C语言小白成长为跨平台向量优化专家。

第一部分:SIMD基础概念

什么是SIMD?

SIMD(单指令多数据流)是一种并行计算方式,它允许一条指令同时操作多个数据。想象一下,你有1000个数字需要加1:

// 传统方式(标量)

for(int i = 0; i < 1000; i++) {

a[i] = a[i] + 1;

}

// SIMD方式(向量)

// 假设向量宽度为256位(8个float)

// 一次可以处理8个数字

for(int i = 0; i < 1000; i += 8) {

vector_add(a[i:i+8], 1);

}为什么需要SIMD?

- 性能提升:理论加速比等于向量宽度/数据宽度

- 功耗效率:相比多线程,SIMD在单核上实现并行

- 现代CPU标配:从嵌入式到服务器都支持SIMD

第二部分:各平台SIMD头文件详解

1. WebAssembly SIMD(wasm_simd128.h)

WebAssembly的SIMD支持128位向量操作,是所有平台中最统一的。

核心数据类型

// 128位向量类型

typedef uint8_t v128_t __attribute__((__vector_size__(16)));

// 具体类型定义

typedef float v128_f32 __attribute__((__vector_size__(16)));

typedef int32_t v128_i32 __attribute__((__vector_size__(16)));主要API分类

1. 内存操作

// 加载操作

v128_t wasm_v128_load(const void* mem);

v128_t wasm_v128_load8_splat(const void* mem); // 复制到所有字节

v128_t wasm_v128_load32_zero(const void* mem); // 加载并清零高位

// 存储操作

void wasm_v128_store(void* mem, v128_t vec);

void wasm_v128_store_lane(void* mem, v128_t vec, int lane);2. 算术运算

// 整数运算

v128_t wasm_i32x4_add(v128_t a, v128_t b);

v128_t wasm_i32x4_sub(v128_t a, v128_t b);

v128_t wasm_i32x4_mul(v128_t a, v128_t b);

// 浮点运算

v128_t wasm_f32x4_add(v128_t a, v128_t b);

v128_t wasm_f32x4_mul(v128_t a, v128_t b);

v128_t wasm_f32x4_div(v128_t a, v128_t b);3. 位操作

v128_t wasm_v128_and(v128_t a, v128_t b);

v128_t wasm_v128_or(v128_t a, v128_t b);

v128_t wasm_v128_xor(v128_t a, v128_t b);

v128_t wasm_v128_not(v128_t a);完整示例:WebAssembly向量加法

#include <wasm_simd128.h>

void vector_add(float* result, const float* a, const float* b, size_t count) {

size_t simd_count = count & ~3; // 对齐到4的倍数

for (size_t i = 0; i < simd_count; i += 4) {

v128_t va = wasm_v128_load(&a[i]);

v128_t vb = wasm_v128_load(&b[i]);

v128_t vresult = wasm_f32x4_add(va, vb);

wasm_v128_store(&result[i], vresult);

}

// 处理剩余元素

for (size_t i = simd_count; i < count; i++) {

result[i] = a[i] + b[i];

}

}2. x86_64平台(immintrin.h)

x86平台拥有最丰富的SIMD指令集历史,从MMX到AVX-512。

数据类型演进

// SSE (128位)

typedef float __m128; // 4个float

typedef double __m128d; // 2个double

typedef int32_t __m128i; // 整数向量

// AVX (256位)

typedef float __m256; // 8个float

typedef double __m256d; // 4个double

typedef int32_t __m256i; // 整数向量

// AVX-512 (512位)

typedef float __m512; // 16个float

typedef double __m512d; // 8个double

typedef int32_t __m512i; // 整数向量内存对齐要求

x86平台对内存对齐有严格要求:

// 使用aligned_alloc或posix_memalign

float* aligned_alloc(size_t count) {

float* ptr;

if (posix_memalign((void**)&ptr, 32, count * sizeof(float)) != 0) {

return NULL;

}

return ptr;

}

// 或者使用编译器属性

float data[1024] __attribute__((aligned(32)));完整的x86 SIMD示例

#include <immintrin.h>

#include <stdio.h>

#include <stdlib.h>

#include <time.h>

// 矩阵转置优化示例

void transpose_4x4_sse(float* dst, const float* src, int src_stride) {

__m128 row0 = _mm_loadu_ps(&src[0 * src_stride]);

__m128 row1 = _mm_loadu_ps(&src[1 * src_stride]);

__m128 row2 = _mm_loadu_ps(&src[2 * src_stride]);

__m128 row3 = _mm_loadu_ps(&src[3 * src_stride]);

// 转置矩阵

__m128 tmp0 = _mm_unpacklo_ps(row0, row1);

__m128 tmp1 = _mm_unpackhi_ps(row0, row1);

__m128 tmp2 = _mm_unpacklo_ps(row2, row3);

__m128 tmp3 = _mm_unpackhi_ps(row2, row3);

_mm_storeu_ps(&dst[0], _mm_movelh_ps(tmp0, tmp2));

_mm_storeu_ps(&dst[4], _mm_movehl_ps(tmp2, tmp0));

_mm_storeu_ps(&dst[8], _mm_movelh_ps(tmp1, tmp3));

_mm_storeu_ps(&dst[12], _mm_movehl_ps(tmp3, tmp1));

}

// AVX优化的向量点积

float dot_product_avx(const float* a, const float* b, size_t count) {

__m256 sum = _mm256_setzero_ps();

size_t simd_count = count & ~7;

for (size_t i = 0; i < simd_count; i += 8) {

__m256 va = _mm256_load_ps(&a[i]);

__m256 vb = _mm256_load_ps(&b[i]);

sum = _mm256_fmadd_ps(va, vb, sum); // 融合乘加

}

// 水平求和

__m128 low = _mm256_castps256_ps128(sum);

__m128 high = _mm256_extractf128_ps(sum, 1);

__m128 sum128 = _mm_add_ps(low, high);

sum128 = _mm_hadd_ps(sum128, sum128);

sum128 = _mm_hadd_ps(sum128, sum128);

float result = _mm_cvtss_f32(sum128);

// 处理剩余元素

for (size_t i = simd_count; i < count; i++) {

result += a[i] * b[i];

}

return result;

}3. ARM64平台(arm_neon.h)

ARM的NEON指令集在移动设备上广泛应用,语法与x86有所不同。

ARM64 NEON数据类型

// 128位向量类型

typedef float32x4_t float32x4_t; // 4个float

typedef int32x4_t int32x4_t; // 4个int32

typedef uint8x16_t uint8x16_t; // 16个uint8

// 64位向量类型

typedef float32x2_t float32x2_t; // 2个float

typedef int32x2_t int32x2_t; // 2个int32ARM64特有功能

#include <arm_neon.h>

// 使用ARM NEON进行图像处理

void rgb_to_grayscale_neon(uint8_t* gray, const uint8_t* rgb, size_t pixel_count) {

uint8x8_t r_factor = vdup_n_u8(77); // 0.299 * 256

uint8x8_t g_factor = vdup_n_u8(150); // 0.587 * 256

uint8x8_t b_factor = vdup_n_u8(29); // 0.114 * 256

size_t simd_count = pixel_count & ~7;

for (size_t i = 0; i < simd_count; i += 8) {

// 加载8个像素的RGB数据

uint8x8x3_t rgb_pixels = vld3_u8(&rgb[i * 3]);

// 计算灰度值

uint16x8_t r = vmovl_u8(rgb_pixels.val[0]);

uint16x8_t g = vmovl_u8(rgb_pixels.val[1]);

uint16x8_t b = vmovl_u8(rgb_pixels.val[2]);

r = vmulq_u16(r, vmovl_u8(r_factor));

g = vmulq_u16(g, vmovl_u8(g_factor));

b = vmulq_u16(b, vmovl_u8(b_factor));

uint16x8_t sum = vaddq_u16(vaddq_u16(r, g), b);

sum = vshrq_n_u16(sum, 8); // 除以256

uint8x8_t gray_pixels = vmovn_u16(sum);

vst1_u8(&gray[i], gray_pixels);

}

// 处理剩余像素

for (size_t i = simd_count; i < pixel_count; i++) {

gray[i] = (rgb[i*3] * 77 + rgb[i*3+1] * 150 + rgb[i*3+2] * 29) >> 8;

}

}4. LoongArch平台(lsxintrin.h, lasxintrin.h)

LoongArch是中国自主研发的指令集架构,支持128位(LSX)和256位(LASX)向量扩展。

LoongArch SIMD数据类型

// 128位向量 (LSX)

typedef float __m128 __attribute__((vector_size(16)));

typedef double __m128d __attribute__((vector_size(16)));

typedef int __m128i __attribute__((vector_size(16)));

// 256位向量 (LASX)

typedef float __m256 __attribute__((vector_size(32)));

typedef double __m256d __attribute__((vector_size(32)));

typedef int __m256i __attribute__((vector_size(32)));LoongArch特有指令示例

#include <lsxintrin.h>

#include <lasxintrin.h>

// 使用LSX进行字符串比较

int strncmp_lsx(const char* s1, const char* s2, size_t n) {

size_t simd_count = n & ~15;

for (size_t i = 0; i < simd_count; i += 16) {

__m128i v1 = __lsx_vld(s1 + i, 0);

__m128i v2 = __lsx_vld(s2 + i, 0);

__m128i cmp = __lsx_vseq_b(v1, v2);

int mask = __lsx_vpickve2gr_w(cmp, 0);

if (mask != 0xFFFF) {

// 找到不同的字节

for (int j = 0; j < 16; j++) {

if (s1[i+j] != s2[i+j]) {

return (unsigned char)s1[i+j] - (unsigned char)s2[i+j];

}

}

}

}

// 处理剩余字符

for (size_t i = simd_count; i < n; i++) {

if (s1[i] != s2[i]) {

return (unsigned char)s1[i] - (unsigned char)s2[i];

}

if (s1[i] == '\0') {

return 0;

}

}

return 0;

}5. RISC-V平台(riscv_vector.h)

RISC-V的向量扩展(RVV)采用可变向量长度设计,是最先进的SIMD实现之一。

RISC-V向量编程模型

#include <riscv_vector.h>

// RVV使用vfloat32m1_t等类型表示向量

// 向量长度在运行时确定

// 向量加法示例

void vector_add_rvv(float* c, const float* a, const float* b, size_t n) {

size_t vl; // 向量长度

for (size_t i = 0; i < n; i += vl) {

vl = vsetvl_e32m1(n - i); // 设置向量长度

vfloat32m1_t va = vle32_v_f32m1(&a[i], vl);

vfloat32m1_t vb = vle32_v_f32m1(&b[i], vl);

vfloat32m1_t vc = vfadd_vv_f32m1(va, vb, vl);

vse32_v_f32m1(&c[i], vc, vl);

}

}

// 更复杂的例子:向量归一化

void normalize_rvv(float* vec, size_t n) {

size_t vl;

vfloat32m1_t vsum = vfmv_v_f_f32m1(0.0f, 1); // 初始化累加器

// 计算平方和

for (size_t i = 0; i < n; i += vl) {

vl = vsetvl_e32m1(n - i);

vfloat32m1_t v = vle32_v_f32m1(&vec[i], vl);

vfloat32m1_t vsq = vfmul_vv_f32m1(v, v, vl);

vsum = vfredosum_vs_f32m1_f32m1(vsum, vsq, vsum, vl);

}

// 计算平方根

float sum = vfmv_f_s_f32m1_f32(vsum);

float norm = sqrtf(sum);

// 归一化

for (size_t i = 0; i < n; i += vl) {

vl = vsetvl_e32m1(n - i);

vfloat32m1_t v = vle32_v_f32m1(&vec[i], vl);

vfloat32m1_t vdiv = vfdiv_vf_f32m1(v, norm, vl);

vse32_v_f32m1(&vec[i], vdiv, vl);

}

}第三部分:跨平台SIMD编程策略

1. 使用SIMDe实现跨平台兼容

SIMDe是一个神奇的库,它可以在不支持原生SIMD的平台上模拟SIMD指令:

#include "simde/simde-common.h"

#include "simde/x86/sse2.h"

// 使用SIMDe编写的跨平台代码

void vector_add_portable(float* result, const float* a, const float* b, size_t count) {

size_t simd_count = count & ~3;

for (size_t i = 0; i < simd_count; i += 4) {

simde__m128 va = simde_mm_loadu_ps(&a[i]);

simde__m128 vb = simde_mm_loadu_ps(&b[i]);

simde__m128 vr = simde_mm_add_ps(va, vb);

simde_mm_storeu_ps(&result[i], vr);

}

// 处理剩余元素

for (size_t i = simd_count; i < count; i++) {

result[i] = a[i] + b[i];

}

}2. 条件编译策略

#if defined(__wasm_simd128__)

// WebAssembly SIMD代码

#elif defined(__SSE2__)

// x86 SSE2代码

#elif defined(__ARM_NEON)

// ARM NEON代码

#elif defined(__loongarch_sx)

// LoongArch LSX代码

#elif defined(__riscv_vector)

// RISC-V向量代码

#else

// 回退到标量代码

#endif第四部分:内存对齐的最佳实践

1. 各平台对齐要求

| 平台 | 指令集 | 对齐要求 |

|---|---|---|

| x86 | SSE | 16字节 |

| x86 | AVX | 32字节 |

| x86 | AVX-512 | 64字节 |

| ARM | NEON | 16字节 |

| ARM | SVE | 16字节 |

| LoongArch | LSX | 16字节 |

| LoongArch | LASX | 32字节 |

| RISC-V | RVV | 8字节 |

| WebAssembly | SIMD128 | 16字节 |

2. 跨平台内存对齐方案

// 通用对齐分配器

typedef struct {

void* ptr;

size_t size;

size_t alignment;

} aligned_buffer_t;

aligned_buffer_t* aligned_alloc(size_t size, size_t alignment) {

aligned_buffer_t* buf = malloc(sizeof(aligned_buffer_t));

if (!buf) return NULL;

// 分配对齐的内存

#ifdef _WIN32

buf->ptr = _aligned_malloc(size, alignment);

#else

if (posix_memalign(&buf->ptr, alignment, size) != 0) {

free(buf);

return NULL;

}

#endif

buf->size = size;

buf->alignment = alignment;

return buf;

}

void aligned_free(aligned_buffer_t* buf) {

if (!buf) return;

#ifdef _WIN32

_aligned_free(buf->ptr);

#else

free(buf->ptr);

#endif

free(buf);

}第五部分:实战项目:跨平台图像处理库

让我们综合运用所学知识,创建一个高性能的跨平台图像处理库:

// image_processor.h

#ifndef IMAGE_PROCESSOR_H

#define IMAGE_PROCESSOR_H

#include <stddef.h>

#include <stdint.h>

// 跨平台向量类型定义

#if defined(__wasm_simd128__)

#include <wasm_simd128.h>

typedef v128_t vec_f32;

#elif defined(__AVX2__)

#include <immintrin.h>

typedef __m256 vec_f32;

#elif defined(__SSE2__)

#include <immintrin.h>

typedef __m128 vec_f32;

#elif defined(__ARM_NEON)

#include <arm_neon.h>

typedef float32x4_t vec_f32;

#elif defined(__loongarch_asx)

#include <lasxintrin.h>

typedef __m256 vec_f32;

#elif defined(__loongarch_sx)

#include <lsxintrin.h>

typedef __m128 vec_f32;

#elif defined(__riscv_vector)

#include <riscv_vector.h>

typedef vfloat32m1_t vec_f32;

#endif

// 图像结构

typedef struct {

uint8_t* data;

int width;

int height;

int channels;

} image_t;

// 核心功能声明

void image_brightness_adjust(image_t* img, float factor);

void image_gaussian_blur(image_t* img, float sigma);

void image_sobel_edge_detect(image_t* img);

#endif // IMAGE_PROCESSOR_H// image_processor.c

#include "image_processor.h"

#include <math.h>

#include <stdlib.h>

// 亮度调整实现

void image_brightness_adjust(image_t* img, float factor) {

size_t pixel_count = img->width * img->height;

size_t simd_count = pixel_count & ~3; // 处理4的倍数

for (size_t i = 0; i < simd_count; i += 4) {

#if defined(__wasm_simd128__)

v128_t pixels = wasm_v128_load(&img->data[i]);

v128_t factor_vec = wasm_f32x4_splat(factor);

// WebAssembly处理...

#elif defined(__AVX2__)

__m256i pixels = _mm256_loadu_si256((__m256i*)&img->data[i]);

// AVX2处理...

#elif defined(__SSE2__) || defined(__ARM_NEON) || defined(__loongarch_sx)

// 128位向量处理...

vec_f32 pixels_f32;

// 转换和处理...

#elif defined(__riscv_vector)

size_t vl = vsetvl_e32m1(4);

vuint8m1_t pixels = vle8_v_u8m1(&img->data[i], vl);

// RVV处理...

#else

// 标量回退

for (int j = 0; j < 4; j++) {

img->data[i+j] = (uint8_t)(img->data[i+j] * factor);

}

#endif

}

// 处理剩余像素

for (size_t i = simd_count; i < pixel_count; i++) {

img->data[i] = (uint8_t)(img->data[i] * factor);

}

}第六部分:性能优化技巧

1. 循环展开

// 4x循环展开

void vector_add_unrolled(float* dst, const float* a, const float* b, size_t n) {

size_t i = 0;

size_t simd_count = n & ~15; // 16的倍数

for (; i < simd_count; i += 16) {

// 加载4组向量

vec_f32 va0 = vec_load(&a[i]);

vec_f32 va1 = vec_load(&a[i+4]);

vec_f32 va2 = vec_load(&a[i+8]);

vec_f32 va3 = vec_load(&a[i+12]);

vec_f32 vb0 = vec_load(&b[i]);

vec_f32 vb1 = vec_load(&b[i+4]);

vec_f32 vb2 = vec_load(&b[i+8]);

vec_f32 vb3 = vec_load(&b[i+12]);

// 并行计算

vec_f32 vc0 = vec_add(va0, vb0);

vec_f32 vc1 = vec_add(va1, vb1);

vec_f32 vc2 = vec_add(va2, vb2);

vec_f32 vc3 = vec_add(va3, vb3);

// 存储结果

vec_store(&dst[i], vc0);

vec_store(&dst[i+4], vc1);

vec_store(&dst[i+8], vc2);

vec_store(&dst[i+12], vc3);

}

// 处理剩余

for (; i < n; i++) {

dst[i] = a[i] + b[i];

}

}2. 软件预取

void vector_add_prefetch(float* dst, const float* a, const float* b, size_t n) {

size_t prefetch_distance = 256; // 预取距离

for (size_t i = 0; i < n; i += 8) {

// 预取未来数据

if (i + prefetch_distance < n) {

#if defined(__x86_64__)

_mm_prefetch(&a[i + prefetch_distance], _MM_HINT_T0);

_mm_prefetch(&b[i + prefetch_distance], _MM_HINT_T0);

#elif defined(__aarch64__)

__builtin_prefetch(&a[i + prefetch_distance], 0, 3);

__builtin_prefetch(&b[i + prefetch_distance], 0, 3);

#endif

}

// 处理当前数据

vec_f32 va = vec_load(&a[i]);

vec_f32 vb = vec_load(&b[i]);

vec_f32 vc = vec_add(va, vb);

vec_store(&dst[i], vc);

}

}第七部分:调试和验证

1. 单元测试框架

#include <stdio.h>

#include <math.h>

#include <time.h>

#include <assert.h>

// 验证函数

int verify_result(const float* result, const float* expected, size_t n, float tolerance) {

for (size_t i = 0; i < n; i++) {

if (fabsf(result[i] - expected[i]) > tolerance) {

printf("Mismatch at index %zu: got %f, expected %f\n",

i, result[i], expected[i]);

return 0;

}

}

return 1;

}

// 性能测试

double benchmark(void (*func)(float*, const float*, const float*, size_t),

float* dst, const float* a, const float* b, size_t n, int iterations) {

// 预热缓存

func(dst, a, b, n);

clock_t start = clock();

for (int i = 0; i < iterations; i++) {

func(dst, a, b, n);

}

clock_t end = clock();

return (double)(end - start) / CLOCKS_PER_SEC / iterations;

}2. 平台检测代码

void print_cpu_info() {

printf("CPU Information:\n");

#if defined(__wasm_simd128__)

printf(" Platform: WebAssembly with SIMD128\n");

#elif defined(__x86_64__)

printf(" Platform: x86-64\n");

#if defined(__AVX512F__)

printf(" SIMD: AVX-512\n");

#elif defined(__AVX2__)

printf(" SIMD: AVX2\n");

#elif defined(__SSE2__)

printf(" SIMD: SSE2\n");

#endif

#elif defined(__aarch64__)

printf(" Platform: ARM64\n");

#if defined(__ARM_FEATURE_SVE)

printf(" SIMD: SVE\n");

#else

printf(" SIMD: NEON\n");

#endif

#elif defined(__loongarch64)

printf(" Platform: LoongArch64\n");

#if defined(__loongarch_asx)

printf(" SIMD: LASX\n");

#elif defined(__loongarch_sx)

printf(" SIMD: LSX\n");

#endif

#elif defined(__riscv)

printf(" Platform: RISC-V\n");

#if defined(__riscv_vector)

printf(" SIMD: Vector Extension\n");

#endif

#endif

}结语

通过本教程,你已经掌握了:

- 五大平台的SIMD编程:WebAssembly、x86_64、ARM64、LoongArch、RISC-V

- 详细的API使用:每个平台的头文件、数据类型、核心函数

- 内存对齐策略:各平台的对齐要求和最佳实践

- 跨平台编程技巧:条件编译、SIMDe库的使用

- 实战项目经验:完整的图像处理库实现

- 性能优化方法:循环展开、软件预取等高级技巧

记住,SIMD编程的关键在于:

- 理解数据并行性:找到算法中可以并行处理的部分

- 注意内存访问模式:连续的内存访问性能最佳

- 合理使用对齐:对齐可以显著提升性能

- 测试所有代码路径:确保标量回退代码的正确性

- 持续学习和实践:SIMD技术在不断演进

现在,你已经具备了在各个平台上编写高性能向量代码的能力。开始你的SIMD编程之旅吧,让你的代码飞起来!

1

1

Sort by:

返回

暂无评论